A l’occasion du SMX Paris 2014, j’ai eu la chance d’avoir pu animer une conférence aux côtés de Zineb Ait Bahajji, (Webmaster Trends Analyst, Google) et Rebecca Birnbaum, (Responsable des partenariats produit, Google). Cette conférence sur le thème « SEO Mobile : les erreurs à ne pas commettre » était modérée par Virgile Juhan (Journaliste, Journal du Net).

A l’occasion du SMX Paris 2014, j’ai eu la chance d’avoir pu animer une conférence aux côtés de Zineb Ait Bahajji, (Webmaster Trends Analyst, Google) et Rebecca Birnbaum, (Responsable des partenariats produit, Google). Cette conférence sur le thème « SEO Mobile : les erreurs à ne pas commettre » était modérée par Virgile Juhan (Journaliste, Journal du Net).

A la fin de la conférence, Virgile Juhan m’a posé une question sur l’impact de la performance sur le référencement. Des pages qui chargent rapidement seront-elles mieux positionnées dans les pages de résultats ? La réponse est : oui, mais indirectement.

Ranking et temps de chargement

Tout d’abord, revenons sur un brevet Google déposé en 2010 qui permet de départager deux pages répondant aux mêmes critères et que l’algorithme positionnerait au même niveau sur une requête.

Si une telle égalité est présente dans les SERP entre deux URL, alors la vitesse de chargement entre en ligne de compte : ça sera même le critère discriminant (ce que confirme Zineb Ait Bahajji). En cas de pertinence similaire avec une autre page, Google donne la priorité à une page plus performante offrant une meilleure expérience utilisateur :

« Given two resources that are of similar relevance to a search query, a typical user may prefer to visit the resource having the shorter load time.«

On peut voir en début d’introduction du brevet :

« This specification describes technologies relating to using resource load times in ranking search results ».

C’est un signal qui peut faire prévaloir un résultat sur un autre en cas de similitude en terme de ranking, mais combien de fois cela se produit-il dans les SERP ?

Vous l’aurez compris, on ne parle pas ici d’un vrai facteur de ranking, mais plutôt d’un signal qui fera pencher la balance en faveur d’un résultat sur l’autre, si l’une des ressources est rapide et l’autre plutôt lente, à pertinence égale.

Performance et incidence indirecte sur le SEO

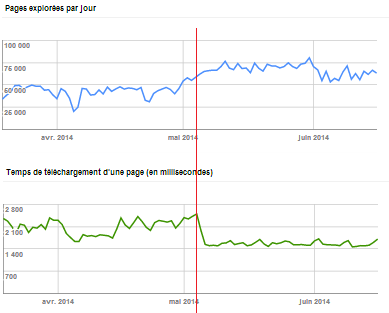

Le temps de téléchargement d’une page par Googlebot a un impact certain sur le taux de crawl. Nous l’avons constaté à plusieurs reprises pour certains de nos clients grâce à Google Webmaster Tools.

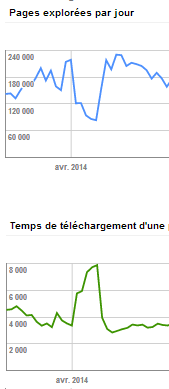

On remarque d’ailleurs que cela fonctionne par palier et volumétrie. Sur les gros sites avec plusieurs centaines de milliers de pages crawlées/jour, la sensibilité est beaucoup plus forte quand un certain palier est franchi. C’est encore plus flagrant dans cet exemple :

Plus les temps de chargement sont élevés, plus le nombre d’éléments crawlés par jour sera faible. Googlebot utilise un temps machine/CPU pour chaque site web, déterminé en fonction de plusieurs paramètres (taille, autorité). Si votre site est lent, il ne pourra pas s’y attarder trop longtemps et préfèrera consacrer ses ressources à d’autres sites Web.

Nouveaux contenus indexés plus tardivement

Cela peut avoir un impact au niveau de nouveaux contenus qui se positionneront en retard par rapport à ceux des concurrents (pages crawlées après d’autres contenus similaires). Ainsi, vos nouveaux contenus perdront l’avantage si il sont indexés après d’autres pages externes similaires. La fraîcheur d’une page pouvant être un élément pris en compte dans le positionnement d’une page.

Prise en compte du maillage interne ralenti

Il est également possible que les facteurs de ranking permettant de positionner vos URL fortes via une stratégie de maillage interne soient amoindris, si le volume de pages crawlées n’est pas aussi élevé que ce qu’il pourrait être avec un site rapide. Le calcul du Pr mettant plus de temps à faire remonter vos pages fortes et pertinentes, si tous les indicateurs qui permettent ce calcul (dans vos contenus et avec la structure de votre site) ne sont pas connus de Google. Ce sont autant de sites externes qui se positionneront pendant ce temps.

Desindexation DC / DUST retardée

Avoir un bon taux de crawl permet également d’accélérer la disparition de pages parasites en cas de duplicate content ou pages non pertinentes indexées alors qu’elles ne devraient pas l’être (robots.txt, ou prise en compte du noindex). Si vous avez des pages catégories dupliquées par exemple et que votre taux de crawl est en baisse, le délai nécessaire à leur disparition de l’index sera plus grand et vous ne bénéficierez pas d’une visibilité optimale, pendant que d’autres sites se positionneront à votre place.

Taux de rebond dégradé

Enfin, en cas d’allers-retours dans les pages de résultats, si une page ne se charge pas assez rapidement et qu’un internaute retourne dans les SERP pour afficher un autre résultat, on entre dans le cas du pogosticking, qui peut avoir une influence sur le classement des pages de résultats.

Temps de chargement : pour Google et l’utilisateur

Pour Google, ce signal n’est pas aussi pertinent et important que d’autre signaux, mais il compte quand même. Rappelons-nous de cet article de 2010 signé Google : http://googlewebmastercentral.blogspot.ch/2010/04/using-site-speed-in-web-search-ranking.html. Le temps de chargement reste un critère à prendre en compte pour toute optimisation de site Web.