Et si Google se servait de notre expression faciale pour déterminer si ses résultats donnent satisfaction ? Un brevet publié par le groupe va dans ce sens.

Depuis l’explosion de l’adoption du mobile, Google s’est mis en ordre de marche pour accompagner l’évolution du comportement des internautes forçant de nombreux sites à revoir leur stratégie SEO. Cela a débuté par la mise à jour mobile-friendly du 21 avril 2015, et s’est poursuivi plus récemment par la création du projet AMP, puis l’annonce du futur index mobile primaire, la promotion de la technologie PWA, etc.

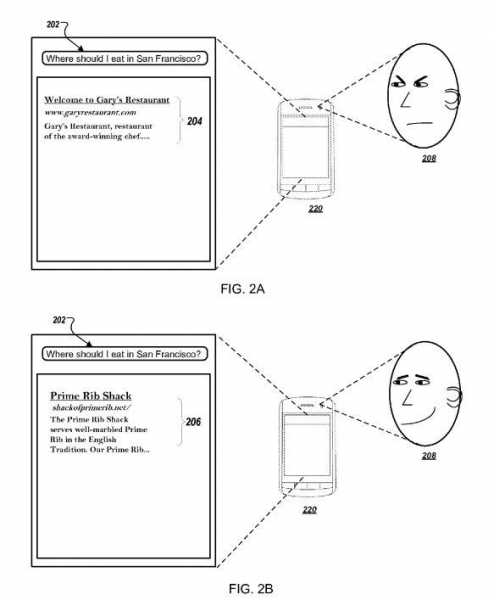

Il est fort probable que le moteur ne s’arrête pas en si bon chemin. Il pourrait se servir du capteur photo frontal de notre smartphone pour analyser notre réaction et adapter ses résultats en conséquence (cf le brevet « Ranking query results using biometric parameters »). Lors de l’installation d’application sur notre téléphone, nous survolons généralement l’écran nous demandant de valider l’accès à certaines de nos données personnelles : contacts, agenda, géolocalisation, et appareil photo. Savez-vous que nous autorisons ainsi d’ores et déjà Chrome ou l’application de recherche officielle de Google à accéder à notre appareil photo ?

Imaginons qu‘un internaute recherche un serrurier proche de chez lui et que les résultats affichés dans Google ne lui apportent pas entière satisfaction : résultats pas assez engageants, trop chers, trop loin, pas ouverts à l’heure de sa recherche, etc. Celui-ci fronce spontanément les sourcils pour marquer son mécontentement. Google pourrait se servir de son appareil photo pour analyser sa réaction et ajuster ses résultats lors de sa prochaine requête pour lui proposer d’autres réponses. A l’inverse, un sourire en coin pourrait être le signe que Google ait apporté une solution satisfaisante à son problème. Le moteur pourrait valider la qualité de ses résultats en fonction du nombre de sourires engendrés. Sans que ce dernier ne s’en rende compte, il devient un « quality rater » au service de l’évaluation et de l’amélioration de l’algorithme de Google.

On sait que Google peut déjà enregistrer notre activité vocale lors d’une recherche. Il est d’ailleurs possible de contrôler ce que le moteur capte de notre voix depuis https://history.google.com/history/. Le moteur pourrait donc commencer dès maintenant à collecter des images de notre faciès pour apprendre à nous connaitre : naturel souriant, tendance à faire la grimace lors de l’utilisation de notre téléphone, visage neutre, etc.

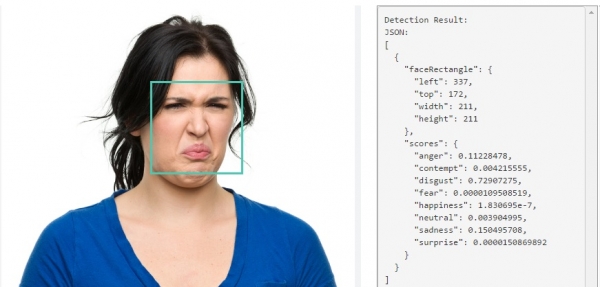

Le brevet accessible ici détaille les points de mesure de données biométriques suivants : la température du corps, le dilatation de la pupille, la crispation des yeux, le rougissement, le clignotement des yeux et la fréquence cardiaque.

En sus des problématiques liées au respect de la vie privée, ce sont les conséquences sur les critères de positionnements SEO qui nous inquiètent tout particulièrement. Les résultats de recherche pourraient en effet s’en trouver chamboulés. La satisfaction de l’internaute reviendrait ainsi au premier plan et on devrait alors se lancer dans la course aux sourires.

Par ailleurs, comment Google interprétera-t-il une réaction de mécontentement pour un résultat qui, pourtant, pourrait apporter une réponse satisfaisante ?

Prenons un exemple en se projetant le soir de l’annonce des résultats du second tour des élections présidentielles. Comment Google interprétera les probables grimaces faites par les électeurs qui découvriront sur leur smartphone le nom du nouvel élu si ce n’était pas leur choix dans l’isoloir ?

Les responsables SEO seront-ils amenés à recommander des optimisations de réjouissance ? Verra-t-on une explosion des sites parodiques dans les résultats de recherche ? Va-t-on évoluer vers une buzzfeed-isation des sites ? Devra-t-on adapter les metas SEO pour y inclure plus de termes déclenchant une réaction ?

Si cette technologie est un jour implémentée dans son algorithme, il est fort probable que Google le réserve à un certain segment de requêtes pour lesquelles les réactions ne peuvent pas être ambiguës : recherche locale, e-commerce, bases de connaissance, etc. Nous pouvons également supposer que la « génération Snapchat » sera plus encline à accepter d’être épiée de la sorte par le moteur. Il est également possible que les impacts ne soient visibles que dans les résultats personnalisés dans un premier temps. De plus, ce nouveau critère viendrait s’ajouter à la centaine de critères de l’algorithme du moteur ce qui noierait son impact.

Enfin, cette technologie pourrait être couplée avec le contexte lié à la recherche : en déplacement près de chez soi ou en vacances ? La nuit ou le matin ? Selon le niveau de santé ? Plus concrètement, Google pourrait savoir si on a bien dormi les jours précédents, si on a fait du sport, si on est sorti tard la veille, l’intensité de la fébrilité avec laquelle on va appuyer sur les liens dans les résultats ou la vitesse avec laquelle on va faire défiler l’écran. Tout est plus ou moins imaginable en termes d’analyse comportementale. L’étude de l’expression du visage serait un des éléments permettant de contextualiser la recherche, soit pour adapter les résultats en amont, soit pour en modifier le classement en mode crowdsourcing.

En voici un exemple d’application. Un homme dont la femme est enceinte et proche du terme (l’analyse des requêtes réalisées au cours des précédents mois apporterait à Google quelques éléments d’informations) recherche « perte des eaux » ou une requête avoisinante. Selon l’état de stress du futur papa, le moteur pourrait remonter en haut des résultats le numéro de l’ambulance la plus proche ou l’itinéraire pour se rendre le plus rapidement possible à la clinique.

On peut s’interroger sur la réelle possibilité d’enregistrer les émotions d’une personne devenant un écran. Il suffit de prendre le métro pour se rendre compte que nos visages restent généralement neutres et statiques lorsque notre regard est tourné vers notre smartphone.

Bien que Google ne soit pas le seul acteur de la tech à s’intéresser à ce sujet (Microsoft se penche également sur la question du développement d’APIs de services cognitifs comme la personnalisation d’éléments en fonction des émotions mesurées à l’image), les contraintes d’interprétation des émotions humaines et les freins liés au cloisonnement de notre vie privée sont telles que la mise en application de cette technologie ne devrait pas voir le jour rapidement.

Source: http://www.journaldunet.com/solutions/expert/66847/expression-faciale—un-brevet-de-google-pour-mesurer-votre-satisfaction.shtml